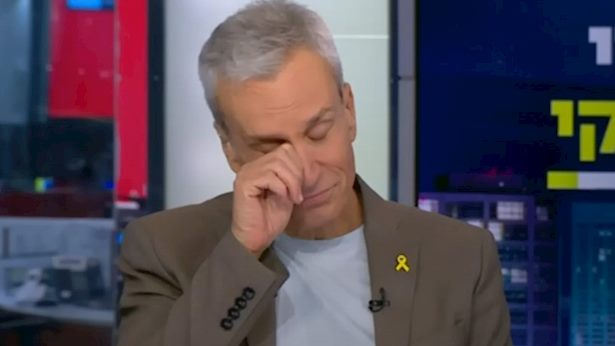

רק לאחרונה מטא פרסמה מסמך מדיניות חדש בשם Frontier AI Framework, שבו היא מציינת כי ייתכן שלא תשחרר מערכות בינה מלאכותית מתקדמות אם הן ייחשבו למסוכנות מדי. המסמך מגדיר מצבים שבהם מערכת AI עלולה שלא לצאת לשוק בשל סיכונים משמעותיים. אולי בגלל זה גם אברי גלעד מגיש קשת 12 מודאג. בטורו השבועי בישראל היום הוא מסביר את הסכנות.

הוא מציין בין הדברים שלו: ”בתוך חמש שנים מהיום – ואולי עוד קודם, כי הבינה דוהרת אין עצור – אתם, ואולי אני, נהיה מחוסרי עבודה ונהפוך לעבדים. במקרה הטוב נקבל קצבאות מהמדינה על אי־עבודה, אבל נהפוך לעבדים של המערכת. לא נהיה עוד עצמאיים לחיות את חיינו. תמורת השכר שנקבל, אם בכלל, נצטרך לציית לאפליקציות שיכפו עלינו האדונים החדשים, אלה שירוויחו מהבינה המלאכותית, שיצברו עוד הון אדיר בעוד הם משאירים אותנו על קצבאות המספיקות למחיה צנועה.

כזכור, לפי מטא, ישנם שני סוגי מערכות AI מסוכנות: “בסיכון גבוה” ו”בסיכון קריטי”. מערכות בסיכון גבוה עשויות להקל על תקיפות סייבר או שימוש בחומרים כימיים וביולוגיים, אך לא באופן עקבי. לעומת זאת, מערכות בסיכון קריטי עלולות לאפשר פגיעה קטסטרופלית שאין לה דרך בלימה במסגרת פריסת המערכת. דוגמאות לסיכונים שמטא ציינה כוללות תקיפה אוטומטית של רשתות מוגנות היטב והפצה של נשק ביולוגי הרסני.

במקרה של מערכת בסיכון גבוה, מטא תעכב את השחרור שלה עד להפחתת הסיכונים לרמה סבירה. אם מערכת מסווגת כבעלת סיכון קריטי, החברה עשויה לעצור את הפיתוח לחלוטין ולנקוט אמצעי אבטחה למניעת דליפת הטכנולוגיה. מסמך המדיניות מצביע גם על רצונה של מטא להציג גישה אחראית יותר, במיוחד לנוכח הביקורת על מדיניות ה-AI הפתוחה שלה, וזאת בהשוואה לחברות כמו OpenAI, שמגבילות גישה למערכות שלהן, ולחברת DeepSeek הסינית, שה-AI שלה מכיל פחות מנגנוני הגנה.